O DuckDuckGo, conhecido mecanismo de busca que prioriza a privacidade, anunciou hoje o lançamento oficial do DuckDuckGo AI Chat, um recurso integrado que permite aos usuários conversar com diferentes modelos de inteligência artificial (IA) de forma totalmente anônima.

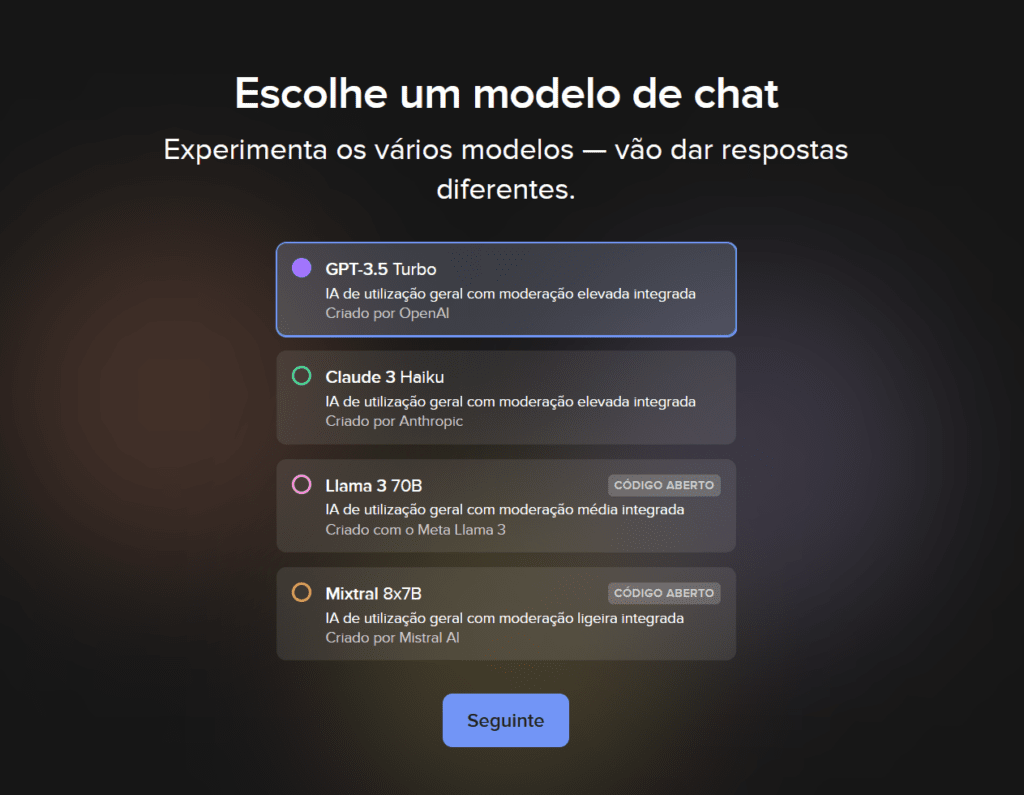

Esta nova funcionalidade gratuita oferece a opção de escolha entre quatro modelos de IA distintos, garantindo a proteção do anonimato do usuário durante a interação.

Para entender melhor essa novidade, vamos nos aprofundar nos detalhes do DuckDuckGo AI Chat.

Acessando o DuckDuckGo AI Chat

O DuckDuckGo anunciou a saída do beta do AI Chat e seu lançamento oficial por meio de uma publicação no blog. De acordo com o anúncio, o DuckDuckGo AI Chat é uma maneira anônima de acessar chatbots populares de IA, incluindo atualmente o GPT 3.5 Turbo da OpenAI, o Claude 3 Haiku da Anthropic e dois modelos de código aberto (Meta Llama 3 e Mixtral 8x7B da Mistral), com a promessa de adição de novas opções no futuro.

Esse recurso opcional é gratuito para uso dentro de um limite diário e pode ser facilmente desativado nas configurações.

Veja como o próprio DuckDuckGo descreve os principais recursos do AI Chat e o que está por vir:

- Conversas privadas e anonimizadas: O DuckDuckGo garante que as conversas sejam privadas, anonimizadas por eles e não utilizadas para nenhum treinamento de modelo de IA.

- Acesso facilitado: O DuckDuckGo AI Chat pode ser encontrado em duck.ai, duckduckgo.com/chat, na página de resultados de pesquisa na aba “Chat” ou por meio dos atalhos !ai e !chat. Todos esses caminhos levam ao mesmo lugar.

- Melhorias a caminho: O DuckDuckGo já planeja melhorias para o futuro, incluindo a adição de mais modelos de bate-papo e pontos de entrada no navegador. Eles também estão explorando um plano pago para acesso a limites de uso diário mais altos e modelos mais avançados.

O DuckDuckGo AI Chat também funciona na Busca privada. Para esclarecer ainda mais a questão da privacidade, a empresa afirma que “os fornecedores do modelo subjacente podem armazenar conversas temporariamente, mas não há como eles vincularem as conversas a você, pessoalmente, pois todos os metadados são removidos.”

Principais funcionalidades do DuckDuckGo AI Chat

Para reforçar a ideia de privacidade, vale destacar alguns dos pontos-chave do DuckDuckGo AI Chat:

- Escolha de modelos de IA: O usuário pode escolher entre diferentes modelos de IA, cada um com suas particularidades e capacidades.

- Anonimato garantido: As conversas não podem ser rastreadas até nenhum usuário individual, pois o DuckDuckGo remove o endereço IP e utiliza o próprio IP da empresa durante a comunicação com os modelos de IA.

- Limpeza do histórico: É possível limpar o histórico de conversas a qualquer momento por meio do botão “Limpar” (Fire Button).

- Armazenamento temporário: Para garantir o funcionamento dos sistemas, os fornecedores dos modelos de IA podem armazenar conversas temporariamente. No entanto, todos os metadados são removidos, tornando impossível vincular a conversa a um usuário específico. Mesmo que você insira seu nome ou outras informações pessoais no chat, os fornecedores do modelo não têm como saber quem digitou o quê.

- Limite de armazenamento: Todos os chats salvos pelos fornecedores dos modelos de IA são completamente excluídos no prazo de 30 dias. Além disso, nenhuma das conversas feitas na plataforma DuckDuckGo pode ser usada para treinar ou melhorar os modelos.

É realmente gratuito?

Sim! O AI Chat é gratuito para usar, respeitando um limite diário – implementado pelo DuckDuckGo para manter o anonimato rigoroso do usuário, assim como acontece com o mecanismo de busca. A empresa planeja manter o nível atual de acesso gratuito e está explorando a possibilidade de um plano pago para acesso a limites mais altos e modelos de bate-papo mais avançados (e caros).

O que vem por aí?

O DuckDuckGo está animado para divulgar o AI Chat, mas já existem melhorias a caminho. A plataforma ficará de olho em novas funcionalidades, como comandos personalizados do sistema e melhorias gerais na experiência do usuário do AI Chat. Eles também planejam adicionar mais modelos de bate-papo, incluindo potencialmente opções hospedadas pelo próprio DuckDuckGo ou pelo usuário. Se você estiver interessado em ver um modelo ou recurso específico de bate-papo adicionado no futuro, informe a empresa por meio do botão “Compartilhar feedback” na tela do AI Chat.

Problemas do não anonimato em outros chats de IA

A integração de chatbots de IA em diversas plataformas online, como o recente lançamento do DuckDuckGo AI Chat, abre um leque de possibilidades para interação e acesso à informação. No entanto, a questão do anonimato nessas interações levanta preocupações cruciais que exigem uma análise aprofundada.

1. Violação de privacidade e segurança:

- Coleta de Dados e Rastreamento: Empresas e desenvolvedores de IA podem coletar e armazenar dados pessoais de usuários durante as conversas em chats de IA, como nome, endereço IP, histórico de conversas e preferências. Essa coleta de dados, sem o consentimento explícito e transparente do usuário, configura-se como uma violação da privacidade.

- Perfis Comportamentais e microtargeting: O uso dos dados coletados pode gerar perfis comportamentais detalhados dos usuários, permitindo o direcionamento preciso de publicidade e propaganda. Essa prática, conhecida como microtargeting, pode influenciar decisões e escolhas dos usuários de forma indevida, além de representar um risco à autonomia individual.

- Falhas de Segurança e Vazamentos de Dados: A natureza digital dos chats de IA os torna vulneráveis a falhas de segurança e vazamentos de dados. Caso ocorram, essas falhas podem expor informações confidenciais dos usuários, como dados bancários, senhas e informações de saúde, causando danos graves à sua reputação e segurança financeira.

2. Viés algorítmico e discriminação:

- Modelos de IA Treinados em Dados Viciados: Modelos de IA que alimentam chatbots são treinados em conjuntos de dados massivos, os quais podem conter vieses e preconceitos preexistentes da sociedade. Isso pode levar à perpetuação de estereótipos e discriminação em suas respostas, causando ofensa e sofrimento a grupos minoritários.

- Falta de Diversidade nas Equipes de Desenvolvimento: A falta de representatividade de diferentes grupos sociais nas equipes de desenvolvimento de IA pode contribuir para a criação de modelos enviesados que não refletem a diversidade da sociedade. Isso reforça as desigualdades existentes e marginaliza grupos minoritários.

- Dificuldade na Detecção e Correção de Viés: Detectar e corrigir vieses algorítmicos em modelos de IA é uma tarefa complexa e desafiadora. Isso se deve à natureza complexa dos algoritmos e à dificuldade em identificar e quantificar os diferentes tipos de vieses presentes nos dados de treinamento.

3. Manipulação e desinformação:

- Propagação de Fake News e Conteúdo Malicioso: Chats de IA podem ser utilizados para propagar notícias falsas, desinformação e conteúdo malicioso, com o objetivo de influenciar a opinião pública, gerar conflitos sociais ou prejudicar a reputação de indivíduos ou empresas.

- Engenharia Social e Ataques de Phishing: A capacidade dos chatbots de IA de simular conversas humanas pode ser usada para realizar engenharia social e ataques de phishing, induzindo usuários a fornecer informações confidenciais ou clicar em links maliciosos.

- Dificuldade na Autenticação de Fontes: A natureza anônima de alguns chats de IA pode dificultar a autenticação da fonte das informações recebidas, tornando os usuários mais suscetíveis à manipulação e à desinformação.

4. Falta de transparência e responsabilidade:

- Algoritmos opacos e Caixa Preta: O funcionamento interno dos modelos de IA que alimentam chatbots nem sempre é transparente, dificultando a compreensão de como as decisões são tomadas e quais dados são utilizados. Essa falta de transparência cria uma “caixa preta” que impede o escrutínio público e a responsabilização das empresas por seus sistemas de IA.

- Desresponsabilização em Casos de Erro ou Dano: Em caso de erros ou danos causados por chatbots de IA, a responsabilidade pode ser difícil de determinar, devido à complexa interação entre os modelos de IA, os desenvolvedores, as empresas e os usuários. Isso cria um ambiente de impunidade e dificulta a busca por justiça em caso de violações.

5. Impacto na saúde mental e bem-estar:

- Interação Desumanizada e Falta de Empatia: A natureza artificial dos chatbots de IA pode gerar uma sensação de desumanização e falta de empatia nas interações, especialmente em situações que exigem apoio emocional ou compreensão profunda de sentimentos complexos.

- Dependência Emocional e Isolamento Social: O uso excessivo de chatbots de IA como fonte principal de interação social pode levar à dependência emocional e ao isolamento social, prejudicando o desenvolvimento de habilidades interpessoais e o bem-estar

Priorizando a privacidade e a responsabilidade

Diante dos desafios apresentados, é fundamental que o desenvolvimento e a utilização de chats de IA sejam guiados por princípios éticos e responsáveis que priorizem a privacidade, a segurança, a transparência e o bem-estar dos usuários.

Medidas Necessárias para um Futuro Positivo:

-

Transparência e Explicabilidade: Desenvolvedores de IA devem garantir a transparência no funcionamento dos modelos de IA, fornecendo documentação detalhada sobre os dados utilizados, os algoritmos envolvidos e os processos de tomada de decisão. Isso permite que usuários e especialistas avaliem os riscos e potenciais vieses dos sistemas de IA.

- Proteção de Dados e Anonimato: A coleta e o armazenamento de dados de usuários em chats de IA devem ser realizados com o consentimento explícito e transparente, com medidas rigorosas de segurança para proteger a privacidade dos dados. O anonimato deve ser uma opção para os usuários que desejam interagir sem revelar suas identidades.

- Diversidade e Inclusão nas Equipes de Desenvolvimento: É crucial promover a diversidade e a inclusão nas equipes de desenvolvimento de IA, garantindo que diferentes grupos sociais sejam representados no processo de criação e avaliação dos modelos. Isso ajuda a mitigar vieses algorítmicos e garantir que os sistemas de IA sejam justos e equitativos para todos.

- Combate ao Viés Algorithmic e à Discriminação: Implementação de técnicas para detectar e corrigir vieses algorítmicos nos modelos de IA é essencial para garantir que os sistemas não perpetuem estereótipos ou discriminem grupos minoritários. Auditorias regulares e testes de viés devem ser realizados para identificar e eliminar potenciais problemas.

- Combate à Manipulação e Desinformação: Implementação de mecanismos para identificar e remover notícias falsas, desinformação e conteúdo malicioso dos chats de IA é fundamental para combater a manipulação da opinião pública e proteger os usuários de informações enganosas.

- Responsabilidade e Algoritmos Auditáveis: Estabelecer mecanismos claros de responsabilidade para empresas e desenvolvedores de IA em caso de erros ou danos causados por seus sistemas é crucial para garantir a justiça e a proteção dos usuários. Algoritmos auditáveis permitem que especialistas examinem o funcionamento dos modelos e identifiquem falhas ou problemas.

- Promoção da Educação e Conscientização: É fundamental promover a educação e a conscientização sobre os riscos e benefícios dos chats de IA, capacitando os usuários para tomar decisões informadas sobre seu uso e proteger sua privacidade e bem-estar.

Os chats de IA têm o potencial de revolucionar a forma como interagimos com a informação e com o mundo digital. No entanto, para que esse potencial seja realizado de forma ética e responsável, é crucial que os desafios relacionados à privacidade, segurança, viés algorítmico e manipulação sejam seriamente considerados e abordados. Através da implementação de medidas robustas de proteção e da promoção de princípios éticos no desenvolvimento e uso de IA, podemos garantir que os chats de IA contribuam para um futuro mais positivo e inclusivo para todos.